Новое слово в аналитике больших данных – гиперконвергентная инфраструктура

Каждая компания по мере становления приходит к осознанию очевидных выгод для бизнеса от анализа больших массивов собственных данных, накопленных за годы работы. Для того, чтобы избежать потерь времени и средств на типичные ошибки, совершаемые от недостатка экспертного опыта и знаний для анализа, перевод бизнеса в цифровое состояние гораздо практичнее осуществлять с помощью готовых, уже проверенных на практике решений.

Каждая компания по мере становления приходит к осознанию очевидных выгод для бизнеса от анализа больших массивов собственных данных, накопленных за годы работы. Для того, чтобы избежать потерь времени и средств на типичные ошибки, совершаемые от недостатка экспертного опыта и знаний для анализа, перевод бизнеса в цифровое состояние гораздо практичнее осуществлять с помощью готовых, уже проверенных на практике решений. Масштабы систем, заказываемые российскими заказчиками для систем хранения, обработки и анализа больших данных, в каждом отдельном случае определяются объемом и функционалом решения, форматом текущих задач заказчика, прогнозов по росту объемов как самих данных, так и количества выполняемых системой задач, требованиям к скорости обработки и анализа данных и т.д. «В следующих релизах платформы HSP показатели масштабируемости будут увеличены, а также, если у заказчиков будут задачи, требующие больших показателей масштабируемости, специалисты HDS готовы провести тесты и предоставить платформу для хранения, обработки и анализа больших данных, удовлетворяющую всем требованиям заказчика», – сказала Ирина Яхина.

Несложный процесс инсталляции HSP позволяет значительно сократить время и пуско-наладочные затраты при запуске проектов аналитики больших данных. Платформа HSP предоставляется заказчикам в виде полностью сконфигурированного и готового к использованию аппаратно-программного решения, установка и настройка которого требует всего нескольких часов. Технология упрощает создание «озера» данных (Data Lake), благодаря которому быстро интегрируются разрозненные наборы информации и решаются сложные аналитические задачи.

На этапе планирования внедрения платформы, совместно с заказчиком заполняется специализированная форма, где определяются параметры инфраструктуры заказчика, а также приложения, которые заказчик планирует развернуть на платформе HSP.

Вместо традиционного применения файловой системы Hadoop Distributed File System (HDFS), платформа HSP использует масштабируемую POSIX-совместимую файловую систему с поддержкой HDFS API. Отказ от HDFS избавляет от ряда ограничений производительности и угрозы сбоев системы распределения данных из-за неисправности распределяющего модуля. Файловая система HSP распределяет метаданные на каждый вычислительный модуль, и, таким образом, каждый из них владеет полной информацией о распределении данных. В то же время HDFS API файловой системы HSP совершенно прозрачен для Hadoop, а совместимость с интерфейсами POSIX обеспечивает сторонним аналитическим инструментам вне Apache Hadoop возможность доступа к данным, сохраненным в HSP, что исключает необходимость извлечения данных для последующего перемещения в другую систему хранения.

«Платформа HSP является решением, которое обеспечивает внутренний мониторинг и восстановление компонентов как на аппаратном уровне, так и на уровне программного обеспечения. Многие ошибки обнаруживаются и устраняются с помощью API-интерфейса RESTful и инструментов управления Hadoop в автоматическом режиме», – поясняет Ирина Яхина. Например, система управления и мониторинга платформой HSP контролирует узлы кластера и службы, запущенные внутри кластера, если обнаруживается ошибка, вышедший из строя узел автоматически перезагружается. Если перезагрузка не приводит к восстановлению работы службы, узел помечается как ошибочный и система мониторинга генерирует сообщение об ошибке с возможностью автоматической отправки сообщения по e-mail. Все службы, функционирующие на данном узле кластера, будут остановлены, но сам узел будет продолжать работать в режиме отладки. Программное обеспечение платформы HSP автоматически производит перезагрузку узла кластера несколько раз, прежде чем отметить узел, как ошибочный.

Кроме того, по словам Ирины Яхиной, платформа HSP обладает системой управления и мониторинга на уровне Hadoop, которая предназначена для обеспечения высокой производительности, надежности и высокой доступности данных. Интерфейсы API, используемые в Hadoop, обеспечивают централизованную конфигурацию сервисов Hadoop (для распределенных приложений и служб, например, HBase), единую службу имен (например, привязку имени хоста к IP-адресу или имени пользователя идентификатору пользователя), взаимодействие группы виртуальных машин, обеспечивающих функционал Hadoop (используется для обнаружения ошибок на уровне виртуальных машин).

Будущее наступило

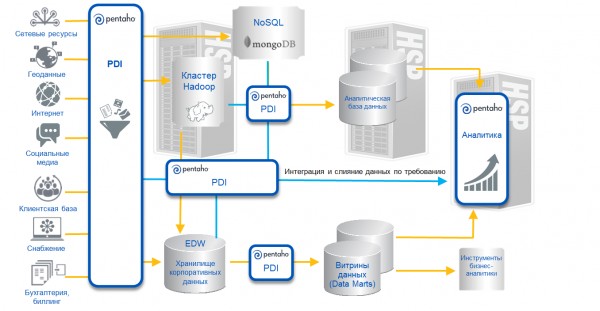

Унифицированная платформа Pentaho представляет собой готовое к работе комплексное решение для интеграции данных и аналитики, способное управлять данными для получения аналитики любого рода в любой среде, в том числе, для больших данных и интернета вещей. Схематически платформа Pentaho представляет комплекс инструментов для интеграции данных (PDI), обеспечивающий возможность трансформирования и «взаимного смешивания» разнообразных типов и форматов данных, включая информацию о транзакциях и неструктурированные данные.

Сверхмасштабируемая платформа Hitachi Hyper Scale-Out Platform серии 400 предусматривает естественную интеграцию с платформой Pentaho Enterprise для создания комплексной программно-определяемой гиперконвергентной платформы с упрощенным управлением потоками информации для аналитики больших данных, с мощной вычислительной функциональностью, широкими возможностями хранения данных и виртуализации. Помимо этого, такое интегрированное решение гарантирует доступность и простоту управления ИТ-системами с возможностью оплаты по мере расширения инфраструктуры (pay-as-you-grow).

Как объединить и управлять данными: возможности Pentaho

Источник: HDS, 2016

Какова специфика обслуживания российских заказчиков систем HSP-Pentaho, возникают ли специфические требования в процессе инсталляции таких систем в России? На этот вопрос Ирина Яхина ответила следующим образом: «В плане гиперконвергентной платформы для хранения, обработки и анализа больших данных HSP и программного обеспечения бизнес-аналитики Pentaho компания HDS предоставляет полный спектр как предпродажной поддержки решения – консультации заказчиков и партнеров, проведение семинаров по теме больших данных и решений HDS в этой области, предоставление документации по продуктам, так и технического обслуживания решений больших данных на сайте заказчика – проведение инсталляций решений, интеграция решений в инфраструктуру заказчика, оперативное устранение технических проблем».

На этапе подготовки технической документации проекта, совместно с представителями заказчика заполняется специальная форма (check list), которая позволяет заранее определить параметры и компоненты инфраструктуры заказчика и быстро и качественно внедрить платформу HSP для решения необходимых задач.

Основной особенностью технического обслуживания платформы HSP и ПО бизнес-аналитики Pentaho является оказание сервиса как по платформе HSP, так и по программному обеспечению Pentaho от одного вендора – компании HDS, так как с 2015 г. компания Pentaho входит в компанию HDS, что приводит к более эффективному оказанию сервисных услуг и обеспечению высоких требований SLA.

Таким образом, особенности и специфика заключается, скорее, не в обслуживании российских заказчиков, а в общей тенденции рынка решений больших данных в России. Например, мировой рынок продуктов и решений в области больших данных, согласно исследованиям американского агентства Wikibon, в 2015 г. составил примерно $33,3 млрд. По прогнозам, к 2020 г. рост рынка достигнет показателя $60 млрд. По данным этого же агентства, каждый год прирост рынка Больших данных составляет порядка 17%.

«По сравнению с мировым трендом, российский рынок технологий больших данных достаточно мал, – поясняет Ирина Яхина. – По данным IDC, в 2014 г. он составил около $340 млн. Следует отметить, что тенденции роста российского рынка значительно превосходят мировые и составляют примерно 40% в год. Решения в области больших данных, на текущий момент, представляют большой интерес для крупных компаний. В государственном секторе данные технологии представлены значительно меньше, чем в банковском секторе и секторе Retail».

Горизонтально масштабируемая архитектура HSP включает единый пользовательский интерфейс с автоматизацией развертывания и управления виртуализированными средами, который подходит для большинства распространенных открытых платформ анализа больших данных, таких как Apache Hadoop и Apache Spark, или коммерческих решений с открытым исходным кодом, таких как Hortonworks Data Platform (HDP).

Сколько и какие степени защиты данных применяются в процессе записи в систему, где и каким образом распределяются автоматически создаваемые копии данных для защиты и восстановления? «Платформа HSP автоматизирует защиту данных, при этом данные записываются на единое хранилище платформы в три места, причем программное обеспечение платформы HSP следит за тем, чтобы данные записывались на разные диски, разные узлы кластера и на узлы кластера, расположенные в разных монтажных шкафах (если система содержит более одного монтажного шкафа)», – разъясняет Ирина Яхина.

Этот алгоритм позволяет обеспечить высокую доступность и надежность хранения данных. Целостность кластера, обеспечивающего функционирование платформы HSP, поддерживается специализированными алгоритмами, которые позволяют отслеживать события на уровне узлов кластера и своевременно сообщать о статусе того или иного узла кластера другим узлам и системе управления и мониторинга, повышая, тем самым, доступность данных, устойчивость функционирования кластера и способности к самовосстановлению системы.

Кроме этого, HDS разработала собственную распределенную файловую систему, которая является одним из основных компонентов платформы HSP. Файловая система eScaleFS имеет ряд преимуществ относительно файловой системы Hadoop Distributed File System (HDFS). Одно из них напрямую касается надежности функционирования. При использовании файловой системы HDFS, существует одно узкое место, это наличие одного узла, который выполняет функции ведущего узла кластера (Master node или Name node), выход из строя этого узла ведет к остановке функционирования кластера Hadoop. В файловой системе eScsleFS каждый узел кластера может самостоятельно и независимо от других узлов осуществлять доступ к данным, без необходимости обмена информацией и доступа к подсистеме хранения через выделенный узел, что позволяет устранить проблему с ведущим узлом кластера и повысить надежность функционирования платформы HSP.

Новая аппаратно-программная платформа HSP в сочетании с программным обеспечением бизнес-аналитики Pentaho, предоставляющая облачную инфраструктуру для внедрения систем анализа больших данных разработана на основе многолетнего опыта специалистов Hitachi Data Systems и Pentaho по решению задач заказчиков в различных отраслях. Внедрение этой доступной по цене платформы на корпоративном уровне позволяет унифицировать всех разрозненные наборы данных и рабочих нагрузок компании, включая устаревшие приложения и хранилища данных.

С появлением платформы HSP в комплексе с программным обеспечением бизнес-аналитики Pentaho, у компании HDS открывается огромный потенциал для предложения решений в области технологий больших данных на российском рынке.